本博客hadoop版本是hadoop 0.20.2。

安装hadoop-0.20.2-eclipse-plugin.jar

- 下载hadoop-0.20.2-eclipse-plugin.jar文件,并添加到eclipse插件库,添加方法很简单:找到eclipse安装目录下的plugins目录,直接复制到此目录下,重启eclipse

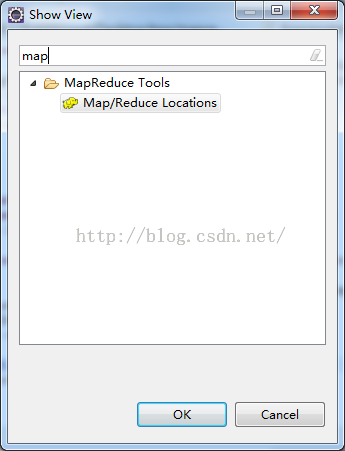

- 依次点击eclipse工具栏的window-----show view ------other在弹出的窗口中输入map,确认找到如下所示

到这里插件安装成功

map/reduce配置

- 配置hadoop installation directory

依次点击eclipse的window-----preference,在弹出的窗口中找到Hadoop Map/Reduce,选择hadoop 安装文件地址(此处的安装文件不需要和集群中的hadoop环境完全一样)

- hadoop map/reduce locations配置

在map/Reduce视图下,点击如下图标

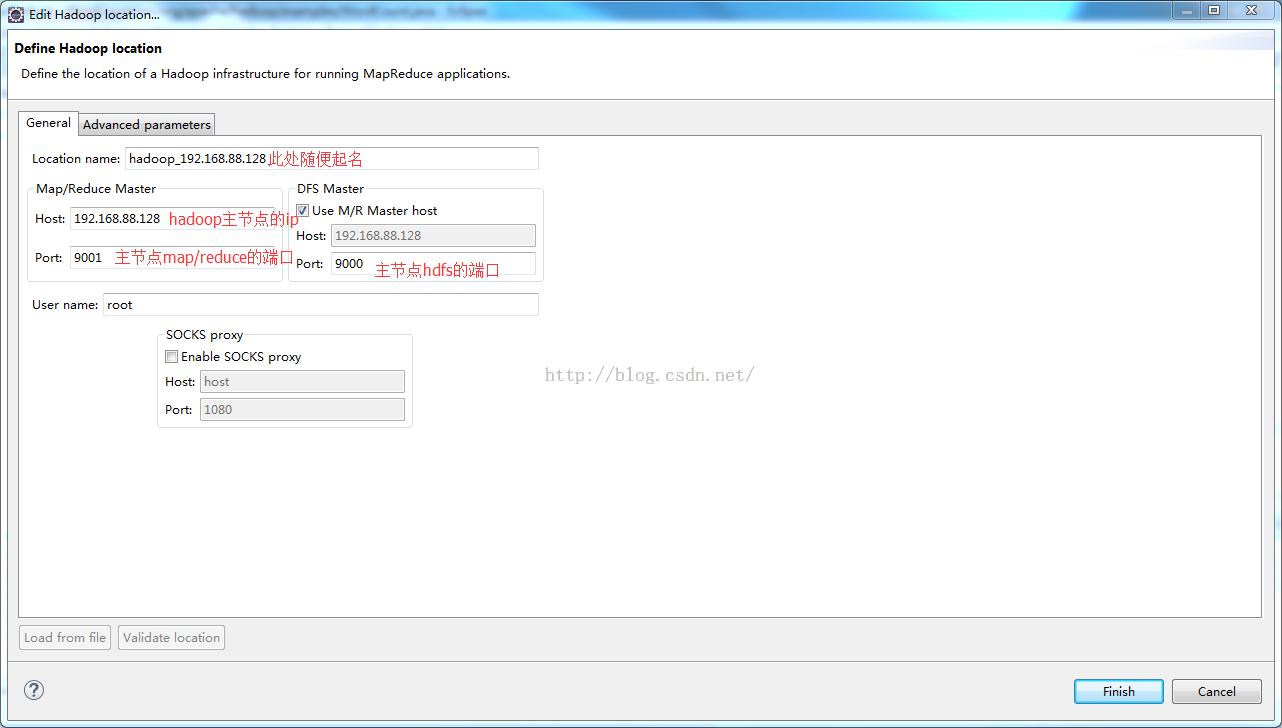

会弹出窗口如下,按照图中提示输入对应的内容

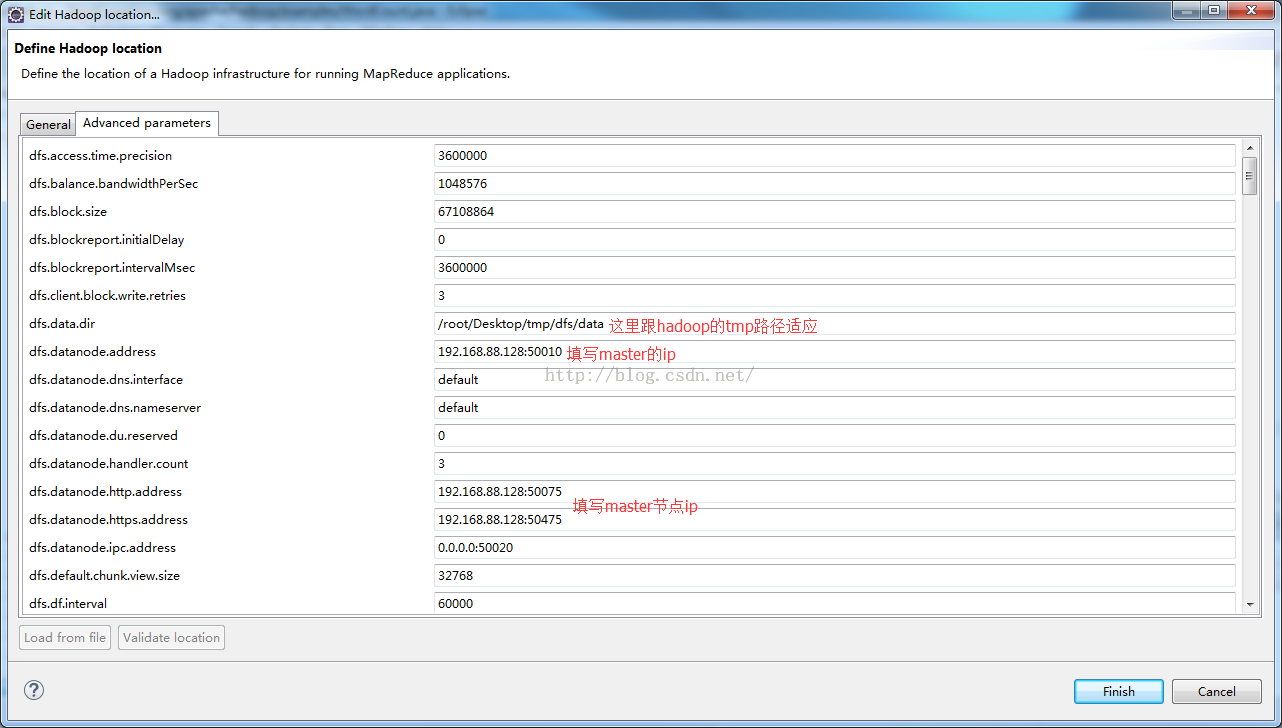

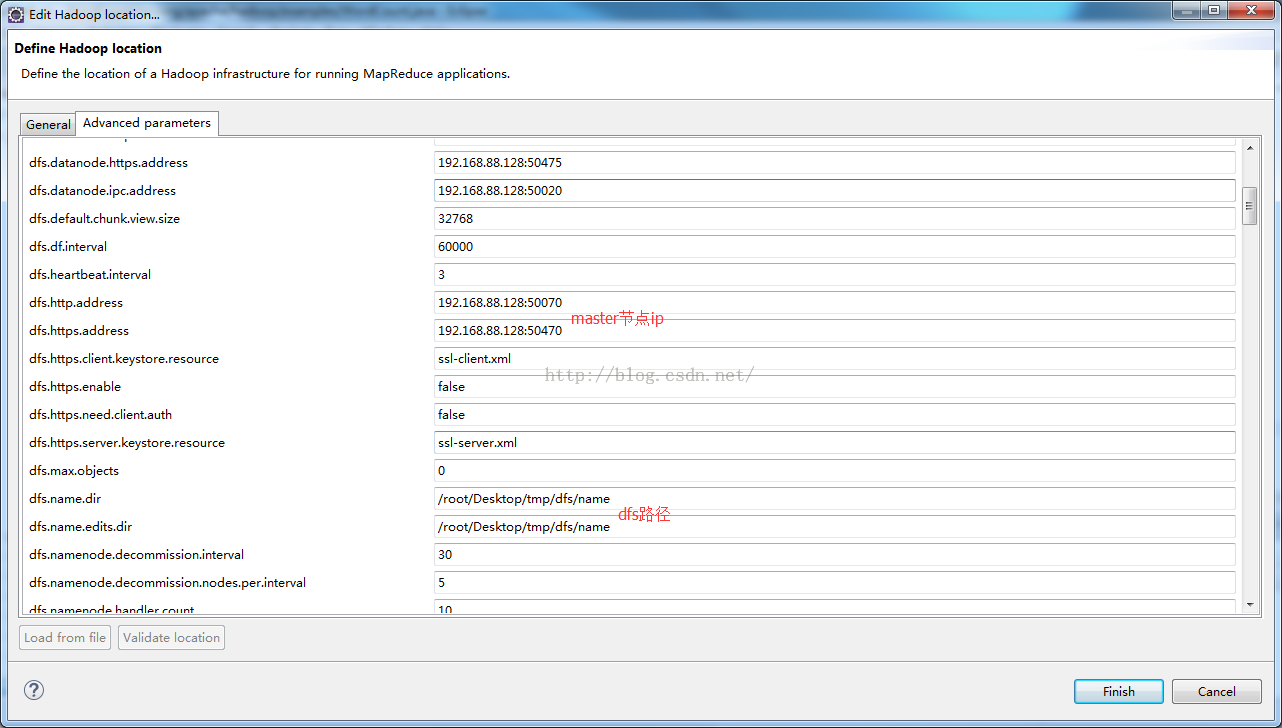

在Advanced Parameters选项卡,输入内容如下,这里我截两个图

其他设置

验证hadoop map/reduce locations配置

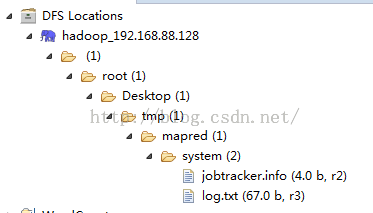

在Map/Reduce的project Explorer视图下,点击dfs下自己配置的map/reduce locations,如果各个节点均可以展开则说明配置没有问题

测试wordcount程序

在hdfs文件系统添加input目录

hadoop fs -mkdir input

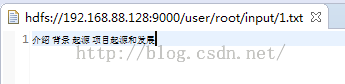

在eclipse刷新dfs locations并上传文件,这里我上传了两个文件,文件内容添加部分空格(wordcount根据空格进行统计单词)

运行wordcount

运行wordcount需要命令行参数,参数有两个,第一个是要统计的文件夹hdfs路径,另一个是输出的路径;

这里注意输出路径是上传文件路径的父目录,填写的时候用dfs locations视图双击文件,即可查看该文件的hdfs路径,我们要的是他的目录,这里就是hdfs://192.168.88.128:9000/user/root/input,另外的一个输出参数我写的是hdfs://192.168.88.128:9000/user/root/output

执行过后刷新dfs locations,可以看到在input同级的目录有了output目录

在master机器上执行命令

hadoop fs -lsr /

也可以看到多出了一个output目录,同时其下边多了个文件,此文件就是统计结果

时间不早了,先写到这里吧,明天我会上传相关的插件,同时会上传几个hadoop相关的pdf文档

版权声明:本文为博主原创文章,未经博主允许不得转载。