Abstract

对抗性训练的生成模型(GAN)最近获得了令人信服的图像合成结果。但是,尽管早期成功地使用GAN进行无监督的表示性学习,但它们很快就被基于自我监督的方法所取代。在这项工作中,我们表明图像生成质量的提升转化为表征学习性能的提高。我们的方法,BigBiGAN,建立在最先进的BigGAN模型之上,通过添加编码器和修改鉴别器来扩展到表征学习。我们广泛评估这些BigBiGAN模型的表示学习和生成能力,证明这些基于生成的模型可以实现在ImageNet上进行无监督表征学习的现有技术,以及无条件图像生成。

1、Introduction

近年来,我们已经看到视觉数据的生成模型的快速进展。虽然这些模型以前仅限于具有单模或少模的结构域,结构简单,低分辨率,但随着建模和硬件的进步,它们已经获得了令人信服地生成复杂,多模态,高分辨率图像分布的能力[1,17,19]。

直观地,在特定域中生成数据的能力需要高度理解所述域的语义。这个想法具有长期的吸引力,因为原始数据既便宜又可以从互联网等来源获得无限供应 - 并且丰富,图像包含的信息远远多于典型的歧视性机器学习模型训练从中预测的类标签。然而,尽管生成模型的进步是不可否认的,但仍存在唠叨的问题:这些模型学习了什么语义,以及它们如何用于表征学习?

仅靠原始数据作为真正理解的手段的生成的梦想几乎没有实现。相反,最成功的无监督学习方法利用了监督学习领域采用的技术,一类已知的方法 - 监督学习[3,38,35,8]。这些方法通常涉及以某种方式改变或阻止数据的某些方面,并训练模型以预测或生成缺失信息的方面。例如,[37,38]提出了彩色化作为无监督学习的手段,其中模型被赋予输入图像中的彩色通道的子集,并且被训练以预测丢失的通道。

作为无监督学习手段的生成模型提供了对自我监督的任务有吸引力的替代方案,因为他们受过训练以模拟完整的数据分布,而无需对原始数据进行任何修改。已经应用于代表性学习的一类生成模型是生成性对抗网络(GAN)[10]。GAN框架中的生成器是从随机采样的潜在变量(也称为“噪声”)到生成的数据的前馈映射,由一个鉴别器提供学习信号以区分实际和生成的数据样本,指导生成器的输出遵循数据分布。对抗推断学习(ALI)和双向GAN(BiGAN)两个方法都是作为GAN框架扩展被提出。使用一个encoder模块将实际数据映射到潜在数据来增强标准GAN,这是生成器学习的映射的逆。

在最优鉴别器的极限中,[4]表明确定性BiGAN的行为类似于自动编码器,最小化L0重构损失;然而,重建误差曲面的形状由参数鉴别器决定,而不是像L2误差这样的简单像素级测量。由于鉴别器通常是一个强大的神经网络,所以希望它会导致错误表面强调重建中的“语义”错误,而不是低级细节。

在[4]中证明了编码器通过BiGAN学习或ALI框架是ImageNet上用于下游任务的可视化表示学习的有效方法。然而,它使用了DCGAN [28]样式生成器,无法在该数据集上生成高质量图像,因此编码器可以建模的这些语法又非常有限。在这项工作中,我们使用BigGAN [1]作为生成器重新审视这种方法,这是一种现代模型,它似乎能够捕获ImageNet图像中存在的许多字节和大部分结构。我们的贡献如下:

- 我们证明了BigBiGAN(带有BigGAN生成器的BiGAN)与ImageNet上最先进的无监督表示学习相匹配。

- 我们为BigBiGAN提出了一个更稳定的联合鉴别器版本。

- 我们对模型设计选择进行了全面的实证分析和消融研究。

- 我们证明,表示学习目标也有助于无条件图像生成,并展示无条件ImageNet生成的最新结果。

2、BigBiGAN

BiGAN [4]或ALI [7]方法被提出作为GAN [10]框架的扩展,其使得能够学习可以用作推理模型[7]或特征表示[4]的编码器。给定一个Px分布的x(例如,图像)和一个Pz分布的潜在z(通常是一个简单的连续分布,如各向同性Gaussian N(0; I)),x的条件分布P(x|z)潜在输入从潜在的Prior Pz采样,如在标准GAN发生器[10]。编码器E模拟逆条件分布P(z|x),从数据分布PD预测latentszgiven dataxsampled。

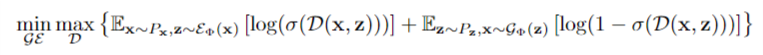

除了添加E,BiGAN框架中对GAN的另一个修改是联合鉴别器D,它将输入数据 - 潜在对(x; z)(而不仅仅是标准GAN中的x)作为输入,并学习区分数据分布和编码器中的对,与生成器和潜在分布。具体地说,它的输入是对(x -Px; ^ z- E(x))和(^ x -G(z); z -Pz),并且G和E的目标是通过制作两个联合分布PxE和PGz来“欺骗”鉴别器这些对的采样难以区分。[4,7]中的对抗性差异目标,类似于GAN框架[10]的目标,定义如下

在这个目标下,[4,7]表明,使用最优D,G和E最小化联合分布PxE和PGz之间的Jensen-Shannon散度,因此在全局最优,两个联合分布PxE = PGz匹配,类似于标准GAN的结果[10]。此外,[4]表明,在E和G都是确定性函数(即,学习的条件分布PG(x|z)和PE(z|x)是Dirac函数)的情况下,这两个函数是全局最优的:例如,所有服从supp(Px)的x = G(E(x)),最优联合鉴别器有效地提高了x重构的建设成本。

虽然我们的方法的关键,BigBiGAN,仍然与BiGAN [4,7]相同,但我们采用了最先进的BigGAN [1]生成图像模型的发生器和鉴别器架构。

除此之外,我们发现改进的鉴别器结构可以在不影响生成的情况下提供更好的代表性学习结果(图1)。也就是说,除了[4,7]中提出的将数据和潜在分布联系在一起的联合鉴别器损失之外,我们在学习目标中提出了额外的一元术语,这些术语仅是数据或者潜在数据的函数。虽然[4,7]证明原始BiGAN目标已经强制说明了联合分布在全局最优匹配,这意味着x和z匹配的边际分布,这些一元术语通过明确地执行这个属性直观地引导了“正确方向”的优化。例如,在图像生成的上下文中,一元损失项与原始GAN目标相匹配,并提供学习信号,该信号仅控制生成器以独立于其潜在输入而匹配图像分布。(在我们的评估中,我们将凭经验证明,这些术语的添加可以改善生成和代表性学习。)

具体地,鉴别器lossLD和编码器 - 发生器lossLEG都是基于标量鉴别器“得分”函数和相应的每样本损失来定义如下:

当h(t)= max(0; 1 - t)是用于规范鉴别器[23,33] 的“枷锁”,也用于BigGAN [1]。鉴别器包括三个子模块:F,H和.J。F仅仅把x作为输入、H则是z,并且用参数x和z学习他们的输出的投影,并且分别标记标量一元得分Sx和Sz。在我们的实验中,x都是图像和潜在的z都是非结构化的平面向量;因此,F是ConvNet,H是MLP。在x和z下的联合得分Sxz由剩余的D子模块给出,J,它是FandH的输出的函数.

E和G的参数被优化以最小化lossLEG,并且参数被优化以最小化lossLD。像往常一样,蒙特卡洛估计的期望值是在小批量上进行的。

3、Evaluation

我们的大多数实验都遵循用于评估无监督学习技术的标准协议,第一次在[37]中提出。我们在未标记的ImageNet上训练BigBiGAN,冻结其学习的表示,然后在其输出上训练线性分类器,使用所有训练集标签进行全面监督。我们还测量图像生成性能,报告初始分数[31](IS)和弗雷切特初始距离[15](FID)作为那里的标准指标。

3.1 Ablation

3.2 Comparison with prior methods

3.3 Reconstruction

4 Related work

基于自我监督的图像中无监督表示学习的许多方法已被证明是非常成功的。自我监督通常涉及从以某种方式设计为类似于监督学习的任务中学习,但是其中“标签”可以自动地从数据本身创建而无需人工操作。一个早期的例子是相对位置预测[2],其中模型在图像块的输入对上训练并预测它们的相对位置。反应性预测编码(CPC)[35,14]是最近的相关方法,其中,给定一个image patch,模型预测哪些补丁出现在其他图像位置。其他方法包括着色[37,38],运动分割[27],旋转预测[8]和样本匹配[5]。还对许多这些方法进行了严格的实证比较[3,21]。BigBiGAN提供的一个关键优势和基于生成模型的其他方法,相对更多自监督方法,是他们的输入可能是全分辨率图像或其他信号,不需要裁剪或修改所需的数据(尽管这些修改可能是有益的数据增强)。这意味着结果表示通常可以直接应用于下游任务中的全数据,而不会发生域移位。

还提出了许多相关的自动编码器和GAN变体。关联压缩网络(ACN)[12]学习通过调节其他先前在代码空间中相似的传输数据的数据来压缩数据集级别,从而产生可以“模糊”语义相似样本的模型,类似于BigBiGAN重建。VQ-VAE [36]将离散(矢量量化)编码器与自回归解码器配对,以高压缩因子产生忠实的重建,并在强化学习设置中展示表示学习结果。在对抗性空间中,对抗性自动编码器[25]提出了一种自动编码器式编码器 - 解码器对,用像素级重建成本训练,用鉴别器代替VAE中使用的先验的KL-发散调节[20]。在另一个提出的VAE-GAN混合[22]中,在大多数VAE中使用的像素空间重建误差被替换为距GAN鉴别器的中间层的特征空间距离。 AGE [34]和-GAN [29]等其他混合方法增加了编码器来稳定GAN训练。许多这些方法和BiGAN [7,4]框架之间的一个有趣的区别是BiGAN没有训练编码器或生成器具有明确的重建成本。虽然可以证明(Big)BiGAN隐含地将重建成本最小化,但定性重建结果(第3.3节)表明这种重构成本具有不同的风格,强调了像素级细节的高级语义。

5 Discussion

我们已经证明,BigBiGAN是一种纯粹基于生成模型的无监督学习方法,它在ImageNet上实现了图像表示学习的最先进结果。我们的消融研究进一步证实了强大的生成模型可以有利于代表学习,反过来学习推理模型可以改进大规模的生成模型。在未来我们希望表示学习可以继续受益于进一步的进化模型和推理模型,以及扩展到更大的图像数据库.

后续。。。。。。。