文章目录

-

- 1. DRN: A Deep Reinforcement Learning Framework for News Recommendation (2018)

-

- (0) 个人小结

- (1) 研究目标

- (2) 背景 & 问题描述

- (3) 研究方法

- (4) 结论与展望

1. DRN: A Deep Reinforcement Learning Framework for News Recommendation (2018)

(0) 个人小结

这篇论文提出了在新闻推荐场景下的深度强化学习框架,将长期利益考虑了进去,并且加入了用户活跃度(根据用户多久返回APP)作为用户的反馈,而不仅仅使用用户是否点击。除此之外,还使用了有效的策略来探索用户的兴趣。

(1) 研究目标

在新闻场景下,提出一个比较新奇的基于深度强化学习的推荐框架。它可以显式地对长远利益建模,除用户是否点击,它还将用户的阅读模式作为刻画用户反馈信息的补充。它还可以推荐一些其他方面用户可能喜欢的新闻,来帮助用户拓展和发现兴趣。

(2) 背景 & 问题描述

背景:

新闻场景下用户兴趣和新闻的特征是动态变化的,在这方面已提出的模型有以下不足:

-

已建模型大多只考虑短期收益的最大化,而没有考虑长期的收益(当前的推荐对未来有什么影响)

例如:用户请求新闻,系统计算得出有两条新闻得分最高且相同,分别是:雷暴预警和球星科比,系统将这两条新闻推荐给用户后。系统可以推测出,在用户阅读雷暴预警的新闻后,他不再需要读这些方面的新闻了,他可能会读更多关于篮球的新闻。即在用户阅读完雷暴预警后,推荐篮球的长远收益更大。

-

少有人考虑除了用户点击、不点击之外的其他反馈,如:用户阅读模式等(用户多久返回这个APP,为每个用户维护一个活跃度)

-

已有的方法容易让用户一直陷入相似的新闻中,造成”信息茧房“,这可能会使用户渐渐觉得所推之物无聊,并且无法帮助用户发现兴趣,或者帮助用户强化其他方面的兴趣。

已有的方法:随机生成

- 可能给用户推荐完全不喜欢的新闻,这在短期会使推荐系统推荐效果下降。

- 短期不能得到相对准确的回报估计,需要多次投递

ps: 新闻特征的动态性这么理解嘞?(新闻过期的非常快,吆西)

问题描述:

提出基于深度强化学习的推荐框架以解决上述其他模型的不足。

(3) 研究方法

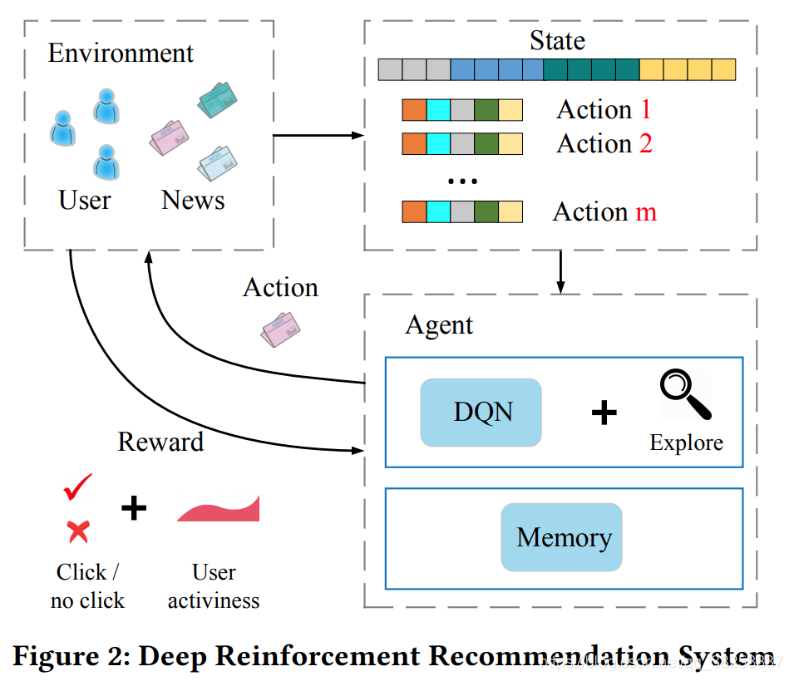

如上图所示,将用户池和新闻池组成了环境,推荐算法作为Agent,状态被定义为用户特征和上下文表示,动作被定义为新闻和用户-新闻交互特征表示。

当用户请求新闻时,状态和动作的集合被传递到Agent,Agent将会选择最好的动作(为用户推荐的新闻列表),并且将用户的反馈作为回报(用户是否点击+用户活跃度)。

图3是模型的框架,该模型分为线下和线上两个部分。

线下模块使用线下用户点击新闻的日志对模型进行训练,将日志转换为四种特征:新闻特征(如:新闻标题、内容、撰写者、点击次数等)、用户特征(如:用户所看的新闻信息、用户点击次数等)、用户新闻交互特征(如:用户阅读的频率等),上下文特征(如:用户看新闻的时间、所看新闻的新鲜度等)。

线上模块使用下面四种方法与用户互动并更新网络:

PUSH:当用户请求新闻时, Agent 根据当前用户的表示特征和候选新闻,生成 top-k 新闻列表,该列表由当前网络和探索网络共同生成;

FEEDBACK:用户收到新闻后,会给出一个反馈;

MINOR UPDATE:使用用户之前的表示特征、所推荐的新闻列表、用户反馈等,并通过比较当前网络Q和探索网络Q~\tilde{Q}Q~?的效果,Agent 更新网络;

MAJOR UPDATE:一段时间时间后,Agent 根据用户反馈和用户活跃度更新网络Q。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-MhFWKRCO-1615903547549)(img/image-20210113200552099.png)]](https://img-blog.csdnimg.cn/20210316220658332.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3FxXzM4MjUzODM3,size_16,color_FFFFFF,t_70)

探索兴趣:

把加了随机干扰的网络作为探索网络,将预测网络的推荐结果以一定的概率和正常的网络推荐结果合并,如果探索网络所推之物汇报更高(用户喜欢),则正常网络将使用探索网络更新。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-doXOSTTl-1615903547551)(img/image-20210113193922976.png)]](https://img-blog.csdnimg.cn/20210316220710836.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3FxXzM4MjUzODM3,size_16,color_FFFFFF,t_70)

(4) 结论与展望

提出了用于新闻推荐的深度强化模型,能够有效的对新闻和用户偏好的动态性建模,除了用户点击与否外,还考虑了用户返回APP的时长。使用了有效的探索策略。

展望:

未来可以考虑区分更细粒度的用户活跃度的测量,区分出重度用户和“一次性用户”。用户活跃度可能和用户所属某种群组有关。