RGB-Infrared Cross-Modality Person Re-Identification via Joint Pixel and Feature Alignment发表在ICCV2019上,是一篇利用GAN来解决基于RGB-IR的ReID问题的文章。

摘要

夜间行人重识别在视频监控、安防等领域有着重要的应用,但是该问题却没有被很好的解决。这主要是因为夜间红外行人图像和日间彩色行人图像之间存在巨大的模态差异,这种差异使得跨模态图像匹配变得更加困难。为了解决夜间行人重识别的问题,本文创新性的提出了像素对齐(Pixel Alignment)的思路来缓解模态差异问题,并提出联合判别(Joint Discriminator)的策略来保持对齐过程中的身份一致性。该方法在目前最具挑战性的夜间行人数据集上,显著高于其他最好方法10%以上。

当前的问题及概述:

传统的方法主要是通过特征表示学习来弥补跨模态和特征对齐之间的差异,其基本思想是通过特征表示学习来匹配真实的RGB和IR图像。由于两种模式之间存在较大的交叉模态差异,因此很难在共享的特征空间中准确地匹配RGB和IR图像。

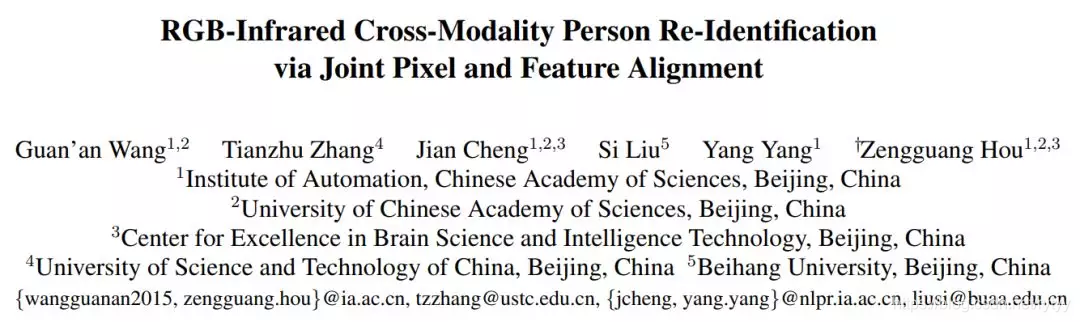

同时,Cross-Modality Person Re-Identification with Generative Adversarial Training提出的CMGAN与本文同属于用GAN网络解决跨模态问题,但是CMGAN的rank1,mAP和ICCS(其中更大的ICCS值意味着更高的相似性):

结果表明,该算法在交叉模态设置下性能较差,不能很好地克服交叉模态变化。

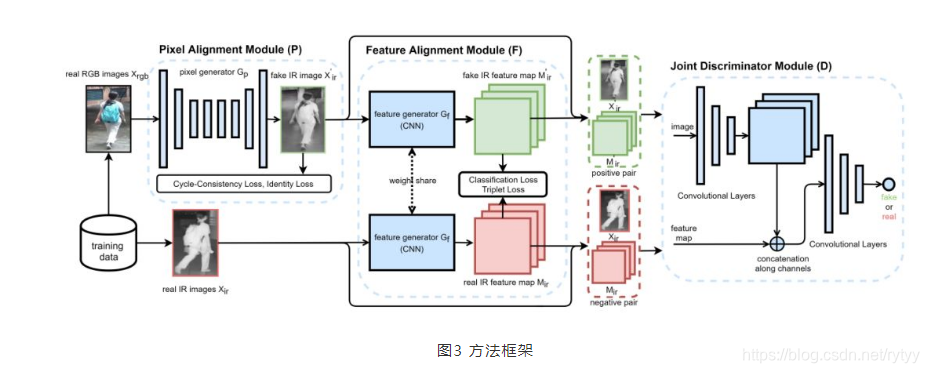

本文提出了一种用于RGB-IR reid任务的端到端对齐生成对抗网络(AlignGAN)。

本文提出的网络有以下几个特点:

- 可以联合利用像素对齐和特征对齐。这是首次为RGB-IR RE-ID问题联合建立两种校准策略的模型。

- 该模型由像素生成器、特征发生器和联合鉴别器组成,这样,不仅能够缓解跨模态和模态内的变化,而且能够学习到身份一致的特征。

- 在SYSU-MM01数据集中,rank -1和mAP分别增长了15.4%和12.9%。

简介

-

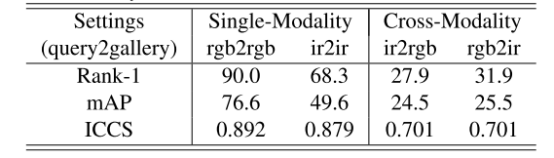

像素对齐模块: 从像素级别缓解模态差异。一个解决思路是通过一个像素对齐模块(Pixel Alignment Module)把RGB图像合成虚拟的infrared图像,然后再匹配虚拟的infrared图像和真实的infrared图像。这样,原本存在于RGB和infrared图像之间的模态差异就可以被虚拟的infrared图像缓解。如图1所示,我们先通过一个像素对齐模块(Pixel Alignment Module)把原本的彩色图像(real RGB images)转化成虚拟的近红外图像(fake IR images),然后通过特征学习的策略来匹配虚拟的近红外图像(fake infraredimages)和真正的近红外图像(real IR images)。

-

-

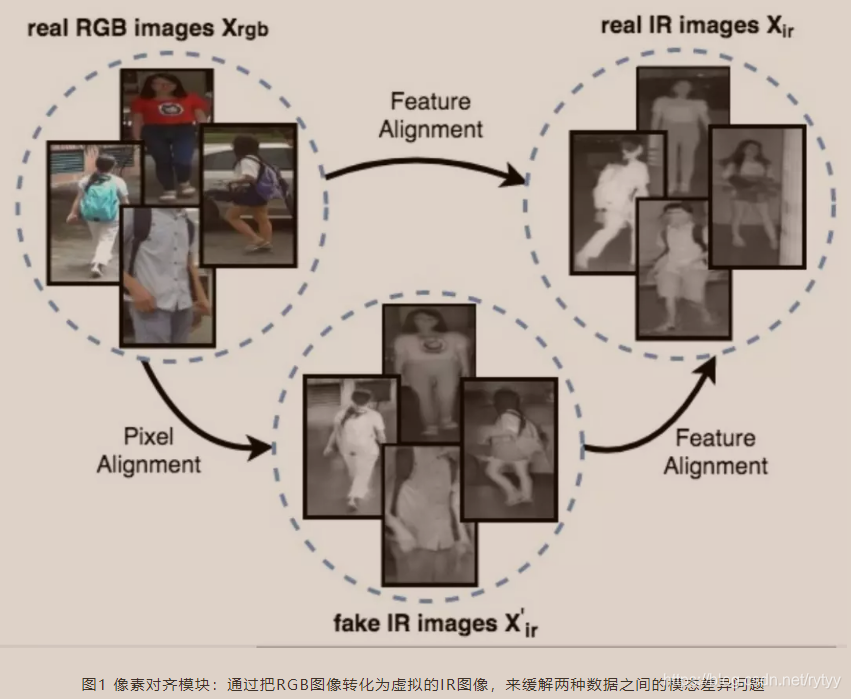

联合判别模块: 考虑身份一致性,保证模态对齐不会引入新噪声。尽管如此,我们仍然面临一个棘手的困难,那就是行人重识别是一个Zero-Shot问题,即测试标签和训练标签是不重合的。因此,在训练过程中,像素对齐和特征对齐模块均无法通过简单的拟合训练集合的标签,来确保推理过程的身份一致性。比如,在特征空间,行人A的彩色数据可能会被对齐到行人B红外数据。这种情况下,虽然模态差异减少了,但是身份信息却丢失了,最终无法进行正确的行人重识别,这是我们不想要的。

为了解决上述问题,我们进一步提出了一个联合判别模块(Joint Discriminator Module)。如图2所示,联合判别模块并不单独最小化RGB和Infrared图像之间,或者RGB和Infrared特征之间的差异,而是最小化RGB和Infrared图像-特征对之间的差异。即,我们优化RGB图像-特征和Infrared图像-特征的联合分布。

具体来说,只有那些有符合红外数据分布的图像和特征,并且图像和特征来自同一个ID的的图像-特征对,联合判别模块才把他判定为真。因此,在这种框架下,我们不仅使得原本的彩色数据(图像或特征)更加接近红外数据(图像或特征)的分布,从而减小模态差异,还可以在对齐过程中,保持图片和特征的原始ID信息。

模型介绍

像素对齐模块(Pixel Alignment Module): 参考CycleGAN方法,我们的像素对齐模块包含两套生成器和判别器。这两套生成器分别用于RGB2IR以及IR2RGB。对应的,两套判别器分别用于判别合成的IR图像和合成的RGB图像。请注意,虽然在训练过程中我们用到了两套生成器和判别器,但是在推理过程中,我们只用了RGB2IR的生成器,去进行像素对齐操作。

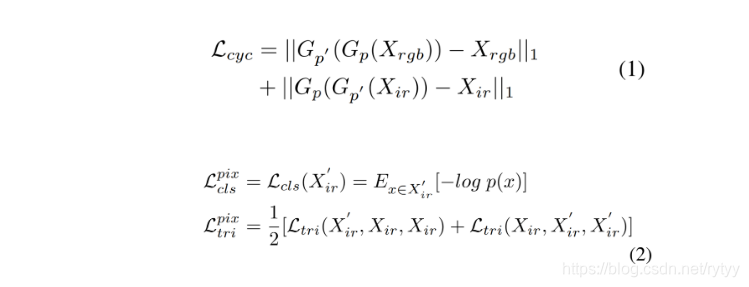

具体来说,我们的像素对齐模块包含一个循环损失(cycle loss)以及一个ID损失(cls+tri)。其中,循环损失使得生成的图片能够保持原有的结构和内容(比如姿态、角度等),ID损失使得合成的图片尽可能和原始图片保持相同的身份信息。这些损失函数分别如公式1,公式2所示。

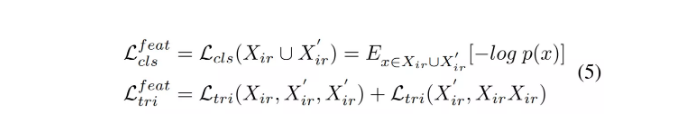

特征对齐模块(Feature Alignment Module) 尽管特征对齐模块可以减少模态间(inter-modality)差异,但是这里仍然存在着很大的模态内(intra-modality)差异,这些差异主要是由于姿态,视角以及光照等因素造成的。为了解决这个问题,我们采用了一个特征对齐模块,把真实的红外图像和合成的红外图像映射到同一个特征空间,并使用基于身份标签的分类和三元组损失来监督特征。对应的损失函数如公式5所示。

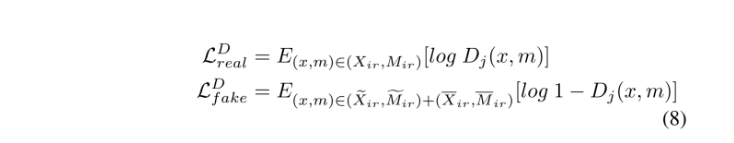

联合判别模块(Joint Discriminator Module)。 根据上述讨论,为了能够更好的保持身份一致性,我们提出了一个联合判别模块,来学习图像-特征对的联合数据分布。具体来说,它的输入为图像-特征对,只有真实的图像和特征,且来自同一个ID,才会被判别为真,否则为假。对应的目标函数如公式8所示。

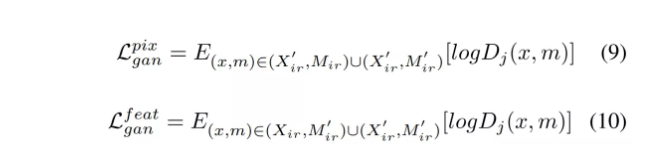

对应的,像素对齐模块和特征对齐模块的对抗损失函数分别如公式9和公式10所示。

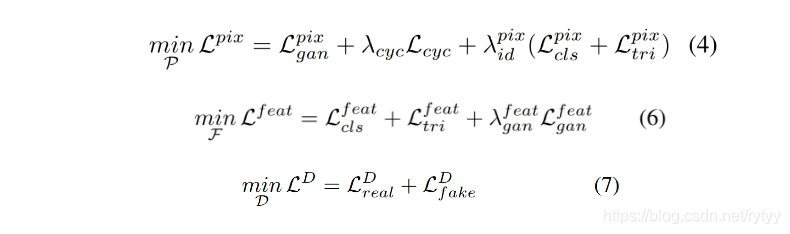

最终,我们的模型可以通过优化如公式4,公式6和公式7所示的目标函数完成。

实验

数据集:SYSU-MM01和RegDB

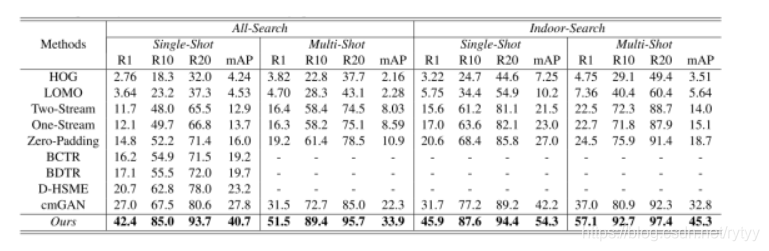

对比:

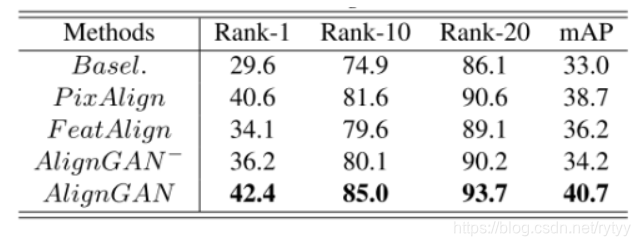

本文的不同变量的对比:

特征空间可视化

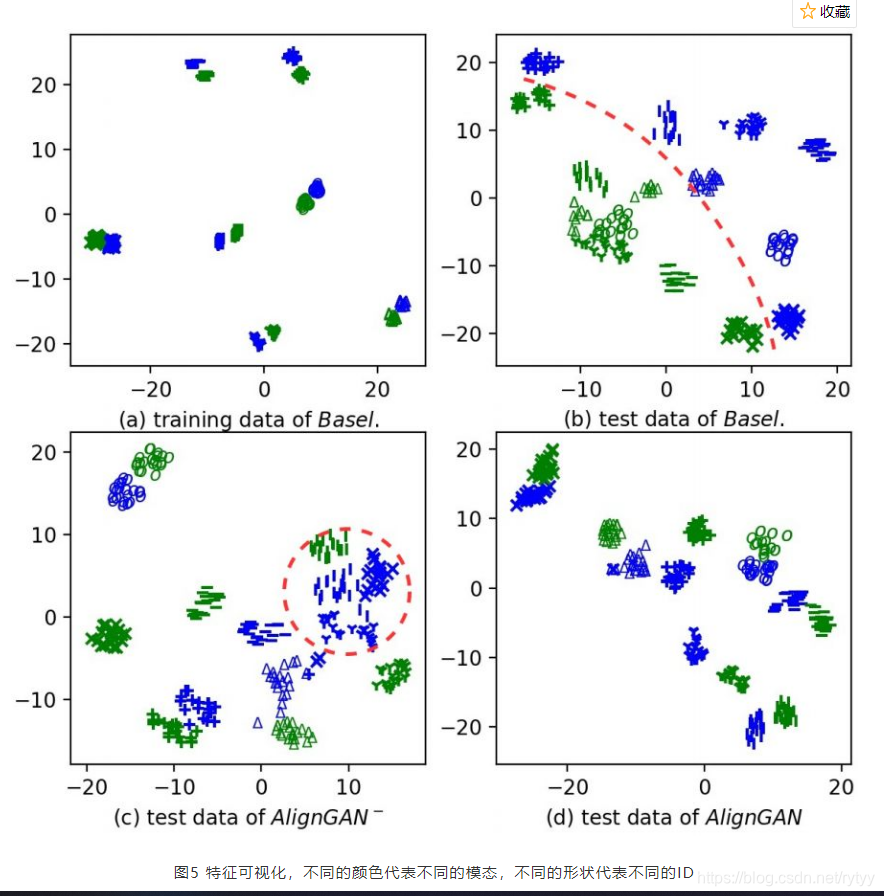

如图5(a)和图5(b)所示,一些简单的baseline方法可以很好的对齐训练数据,但是无法很好的对齐测试数据,说明跨模态差异无法通过简单的特征对齐方法进行解决。如图5?所示,当我们只使用像素对齐模块的时候,模态差异已经被极大的减小了,但是仍然存在一些身份不一致的问题(如红圈所示)。最后,图5(d)表明,当使用了我们的联合判别策略之后,身份一致性可以被很好的保持。

参考资料:

- https://mp.weixin.qq.com/s/T9zbXi9zLG6pOwwPAWdrhQ

- https://blog.csdn.net/qq_41967539/article/details/104282356?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522158364283319724839237170%2522%252C%2522scm%2522%253A%252220140713.130056874%E2%80%A6%2522%257D&request_id=158364283319724839237170&biz_id=0&utm_source=distribute.pc_search_result.none-task