一,基础环境

1、主机名配置

hostnamectl set-hostname node1

hostnamectl set-hostname node2

hostnamectl set-hostname node3vim /etc/hosts

192.168.137.128 node1

192.168.137.129 node2

192.168.137.130 node3

2、安装JDK

tar zxf /root/jdk1.8.0_101.tar.gz -C /data/

echo 'export PATH=$PATH:/data/jdk1.8.0_101/bin' >>/etc/profile

source /etc/profile

3、配置SSH无密码登陆(三台服务器都需要免密)

ssh-keygen

ssh-copy-id -i id_rsa.pub root@node1

二、安装Hadoop2.7.2

1、安装(首先在node1上安装)

mkdir /data/hadoop

mkdir -p /data/hadoop/hdfs

tar zxf hadoop-2.7.2.tar.gz -C /data/hadoop/#设置环境变量

#vim /etc/profile

export HADOOP_HOME=/data/hadoop/hadoop-2.7.2

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$HADOOP_HOME/lib#使环境变量生效

source /etc/profile

2、配置

(1)配置hadoop-env.sh

cd /data/hadoop/hadoop-2.7.2/etc/hadoop

export JAVA_HOME=/data/jdk1.8.0_101

(2)配置yarn-env.sh

export JAVA_HOME=/data/jdk1.8.0_101

(3)配置core-site.xml

<configuration>

<property><name>fs.default.name</name><value>hdfs://node1:9000</value><description>HDFS的URI,文件系统://namenode标识:端口号</description>

</property><property><name>hadoop.tmp.dir</name><value>/data/hadoop/tmp</value><description>namenode上本地的hadoop临时文件夹</description>

</property>

</configuration>

(4)配置hdfs-site.xml

<configuration>

<!-- 设置namenode的http通讯地址 --><property><name>dfs.namenode.http-address</name><value>node1:50070</value></property><!-- 设置secondarynamenode的http通讯地址 --><property><name>dfs.namenode.secondary.http-address</name><value>node1:50090</value></property><!-- 设置namenode存放的路径 --><property><name>dfs.namenode.name.dir</name><value>/data/hadoop/hdfs/name</value></property><!-- 设置hdfs副本数量 --><property><name>dfs.replication</name><value>1</value></property><!-- 设置datanode存放的路径 --><property><name>dfs.datanode.data.dir</name><value>/data/hadoop/hdfs/data</value></property>

</configuration>

(5)配置mapred-site.xml

mv mapred-site.xml.template mapred-site.xml

<configuration>

<property><name>mapreduce.framework.name</name><value>yarn</value>

</property>

</configuration>

(6)配置yarn-site.xml

<configuration>

<property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value>

</property>

<property><name>yarn.resourcemanager.webapp.address</name><value>${yarn.resourcemanager.hostname}:8088</value>

</property>

</configuration>

(7)配置slaves文件

vim $HADOOP_HOME/etc/hadoop/slaves

node2

node3

到此node1节点配置完成,node2、node3节点与node1节点配置一致,只需在node2和node3上将上述操作重复一遍即可,推荐直接将配置好的安装目录和环境变量复制一份到其他两个节点。

scp -r hadoop/ root@node2:/data

scp -r hadoop/ root@node3:/data

3、启动(node1上执行)

(1)格式化namenode(只需第一次启动时执行)

hdfs namenode -format

(2)启动NameNode 和 DataNode 守护进程

sbin/start-dfs.sh

(3)启动验证

#执行jps命令,有如下进程,说明Hadoop正常启动

15698 Jps

15581 SecondaryNameNode

15406 NameNode

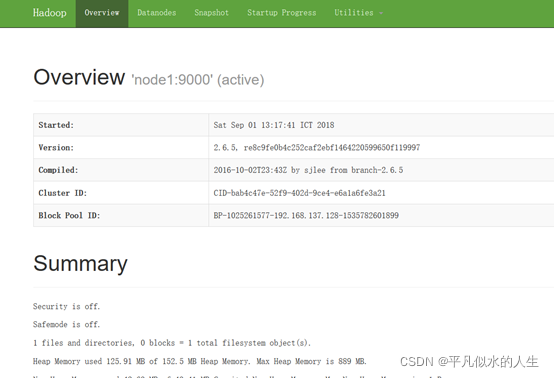

(4)启动成功后可在浏览器输入 http://192.168.137.128:50070 查看hdfs详情

(5)启动ResourceManager 和 NodeManager 守护进程

./start-yarn.sh

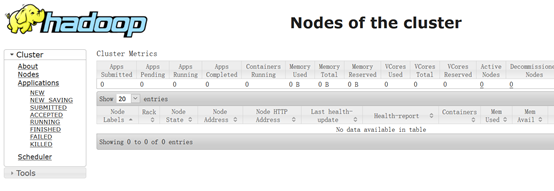

(6)在浏览器中输入:http://192.168.137.128:8088/ 即可看到YARN的ResourceManager的界面