编号按照对应的内容,1-1代表第一大部分遇到的第一题,R代表Review,C代表运行的代码(Code)。

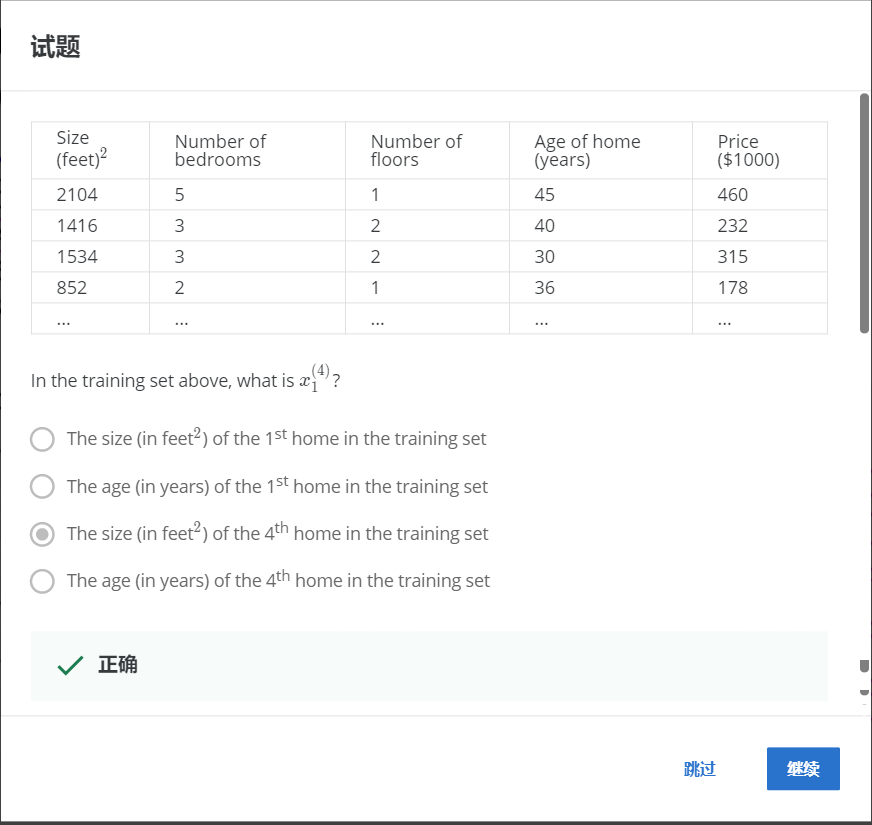

2-1

解:上标代表数据行号,下标代表属性编号。

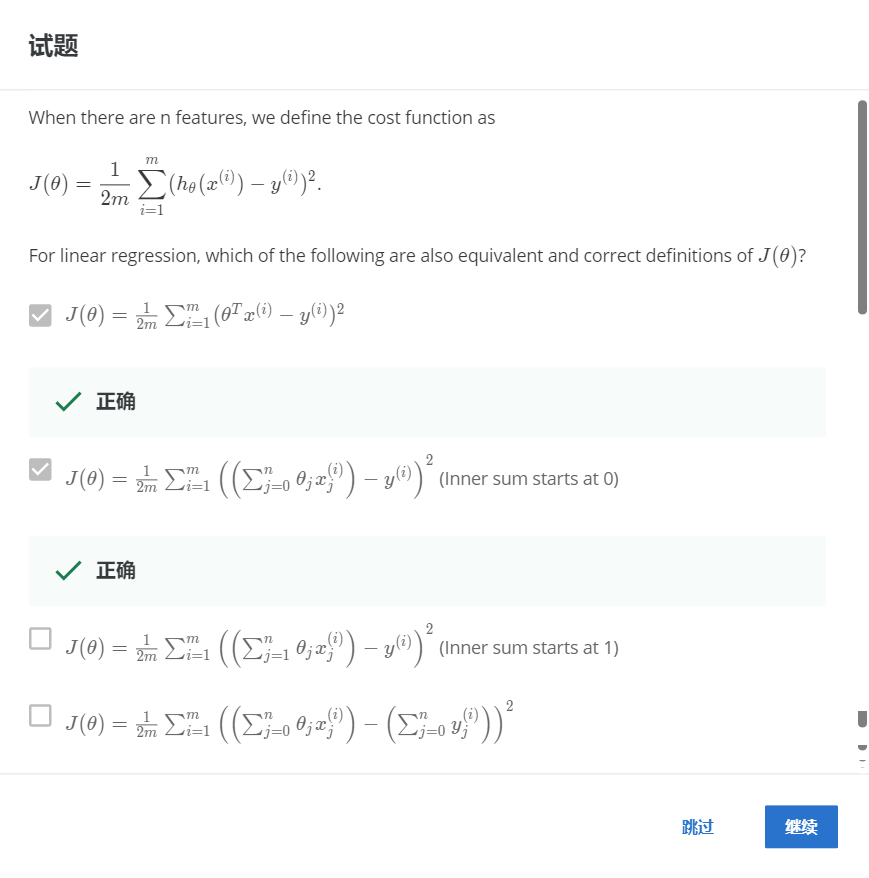

2-2

解:代价函数J的定义已经给出,对于线性回归,下列是正确的J的定义。每个选项的不同点主要在于h函数的选取。

h函数可以用θ向量的转置与x向量相乘,正确。

每一个θ均与对应的x相乘,且必须从0开始,因为x0为常数项,正确。

不正确。

每个数据只有一个预测值,右侧y的值不能累加,不正确。

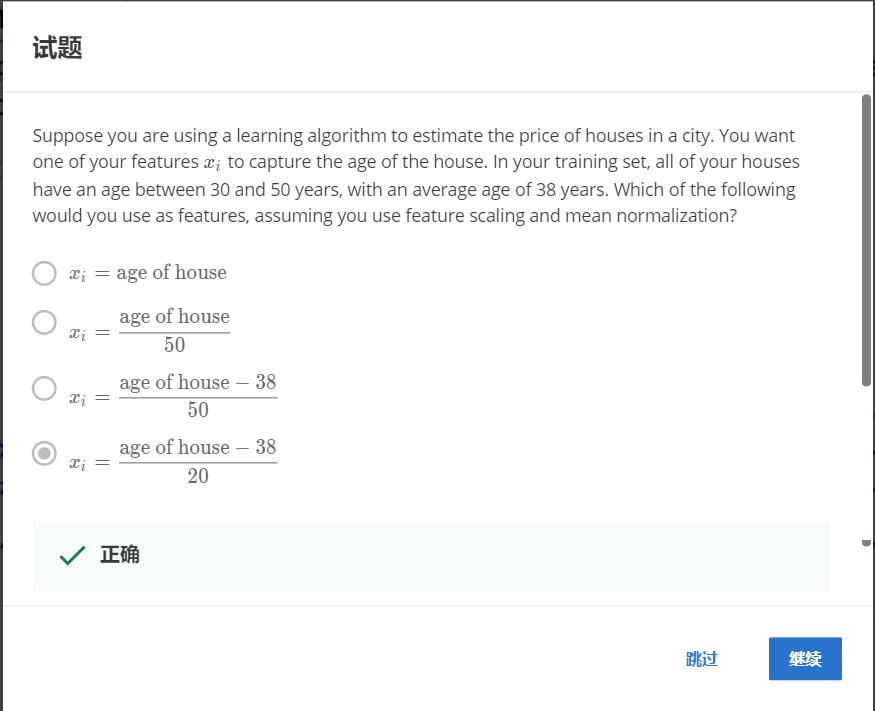

2-3

解:使用特征缩放和均值归一化,您将使用以下哪项作为特征?其中age属性从30到50,平均值为38,根据公式x1=(x1-μ)/s,其中μ是均值,s是最大值减去最小值(标准差也可以)。

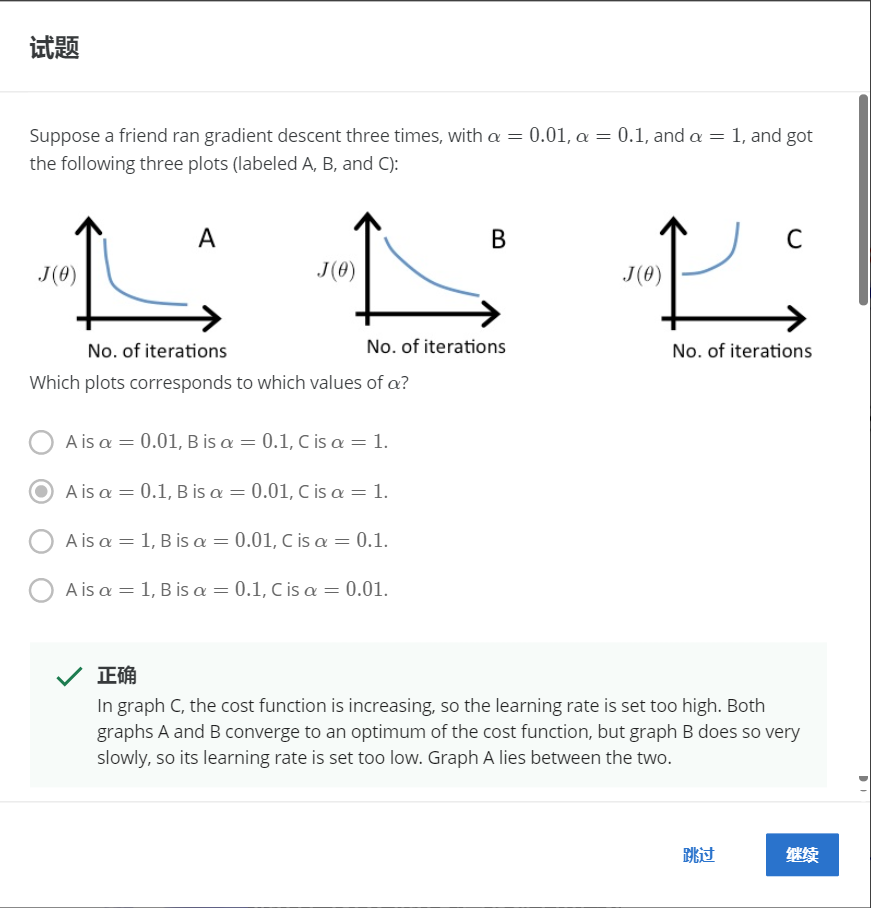

2-4

解:在图 C 中,成本函数在增加,因此学习率设置得太高。 图 A 和图 B 都收敛到成本函数的最优值,但图 B 收敛速度非常慢,因此其学习率设置得太低。 图A介于两者之间。

注意不要误选A。因为B才是很明显的收敛速度过慢。

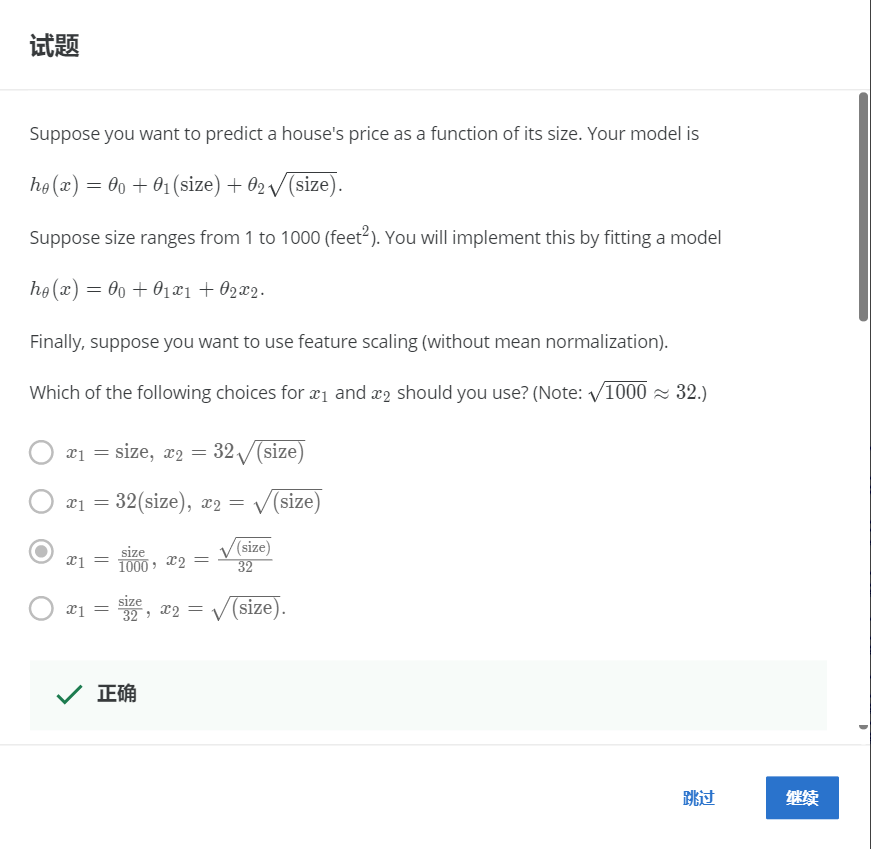

2-5

解:特征缩放,所以x1=x1/1000,带入x1=size,x2=根号(size)即可。

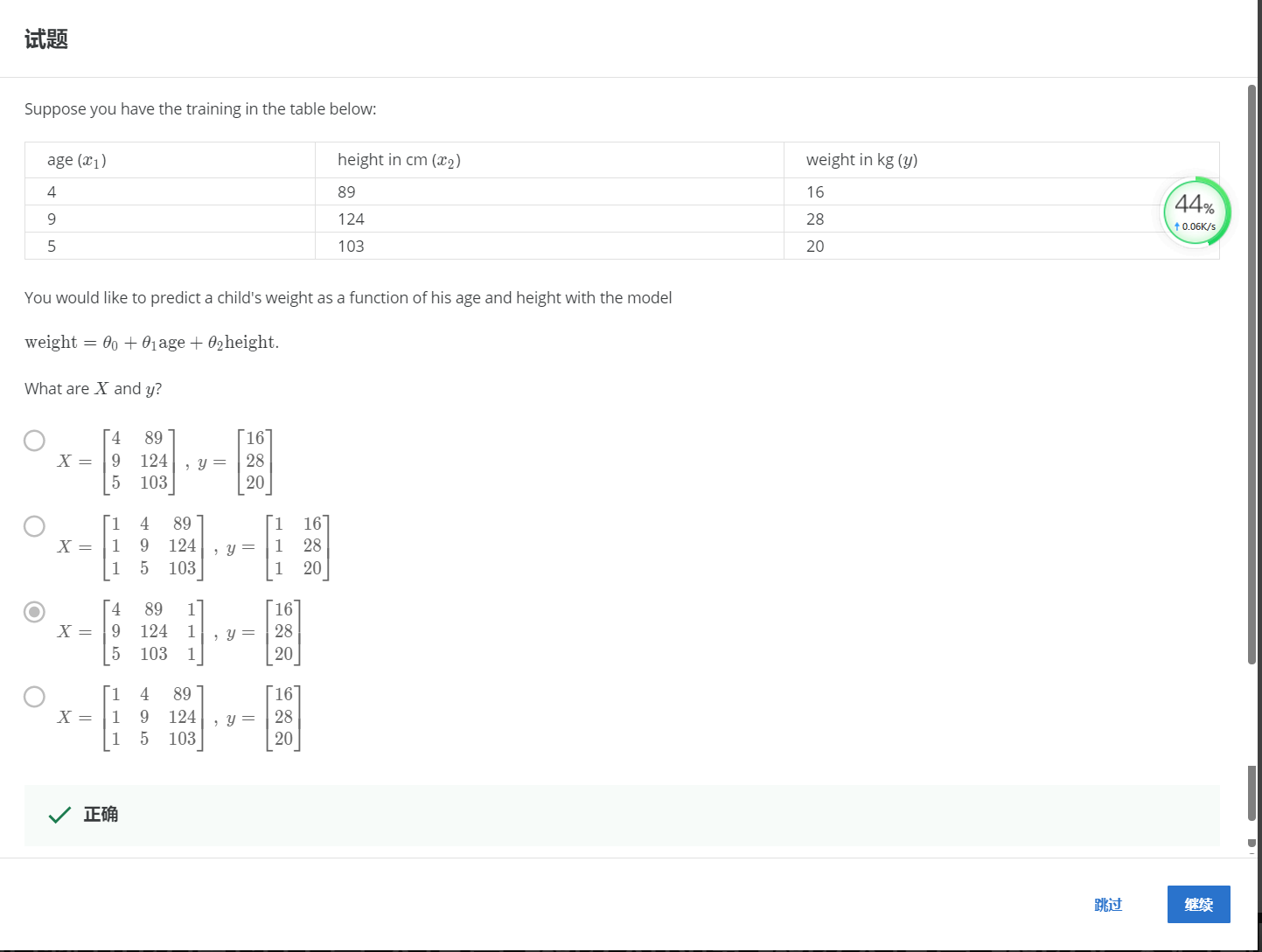

2-6

解:x是m个x向量转置而组成的矩阵,y是m个结果。

R1

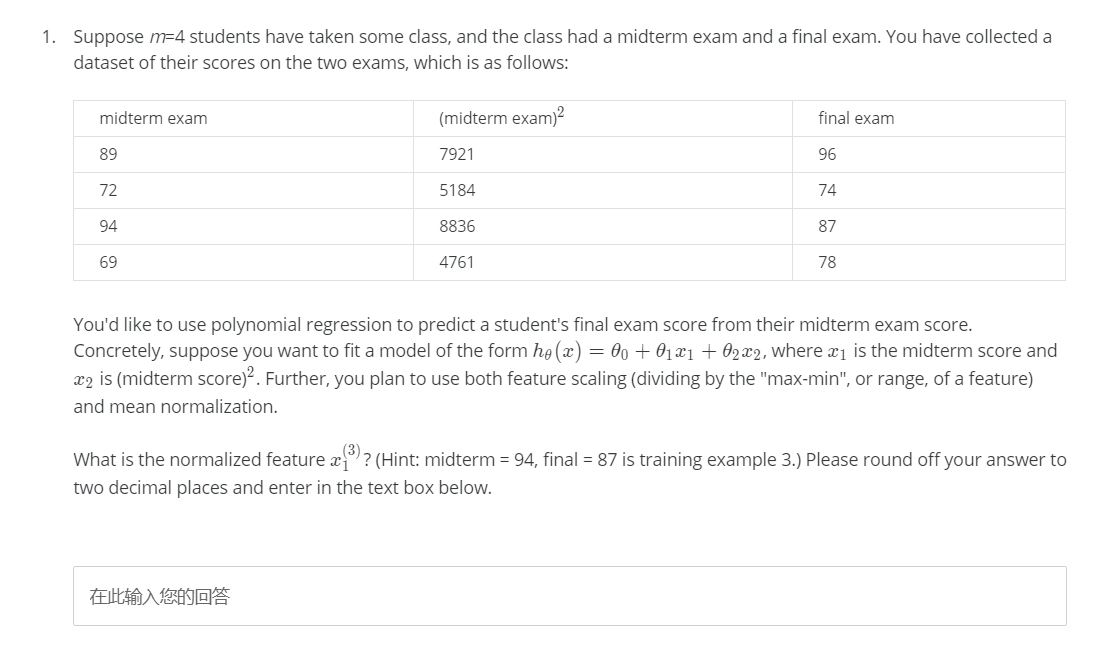

R1-1

解:问第三条数据正则化后的结果,x=(x-μ)/(max-min),带入即可。

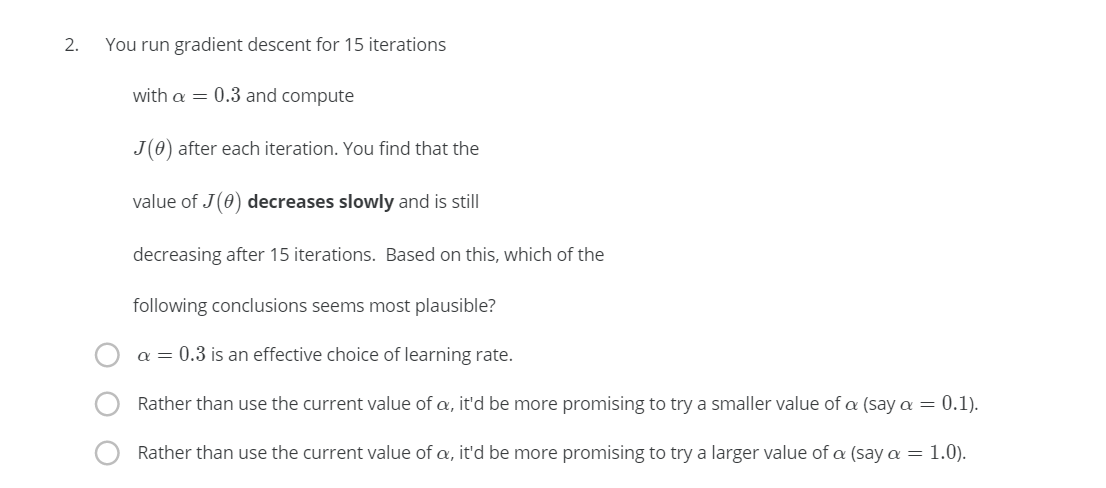

R1-2

解:梯度下降缓慢且15轮迭代后继续下降,说明目前的学习率设置过小。

R1-3

解:y向量为n * 1,x矩阵为m * (n+1),θ向量为(n+1) * 1。

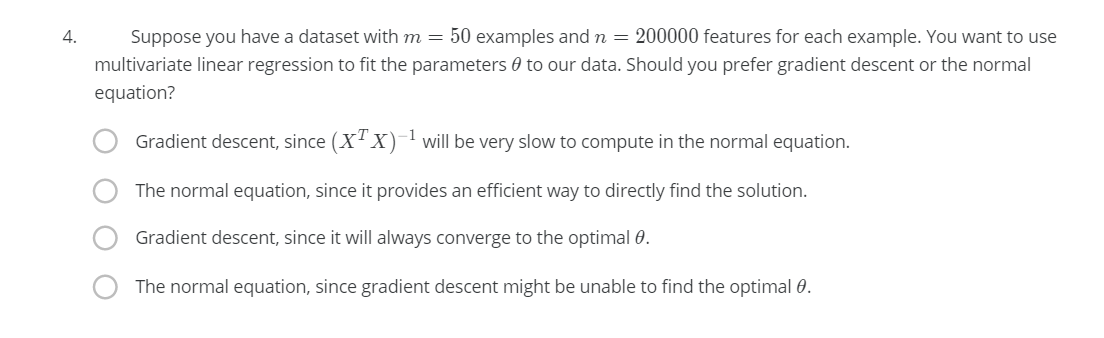

R1-4

解:200000个特征,50个样本,选择梯度下降。特征值过多,正规方程的时间复杂度就越高,因此我们选择梯度下降,是因为计算正规方程比较慢。

R1-5

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-5DEuPdn0-1625993297392)(D:\SystemFiles\Desktop\准备材料\学校\国防科技大学\丁博老师\学习情况\汇报\第五周内容\MachineLearning-Week2\R1-5.png)]

解:特征缩放将各种数值全归一为一个数量级大小的值。它对梯度下降法的帮助是:减少迭代次数,从而加速程序,并不是通过降低每一次迭代的计算成本。正如视频中所说,正规方程不需要特征缩放,因此有关正规方程的两个选项都不选。

R2

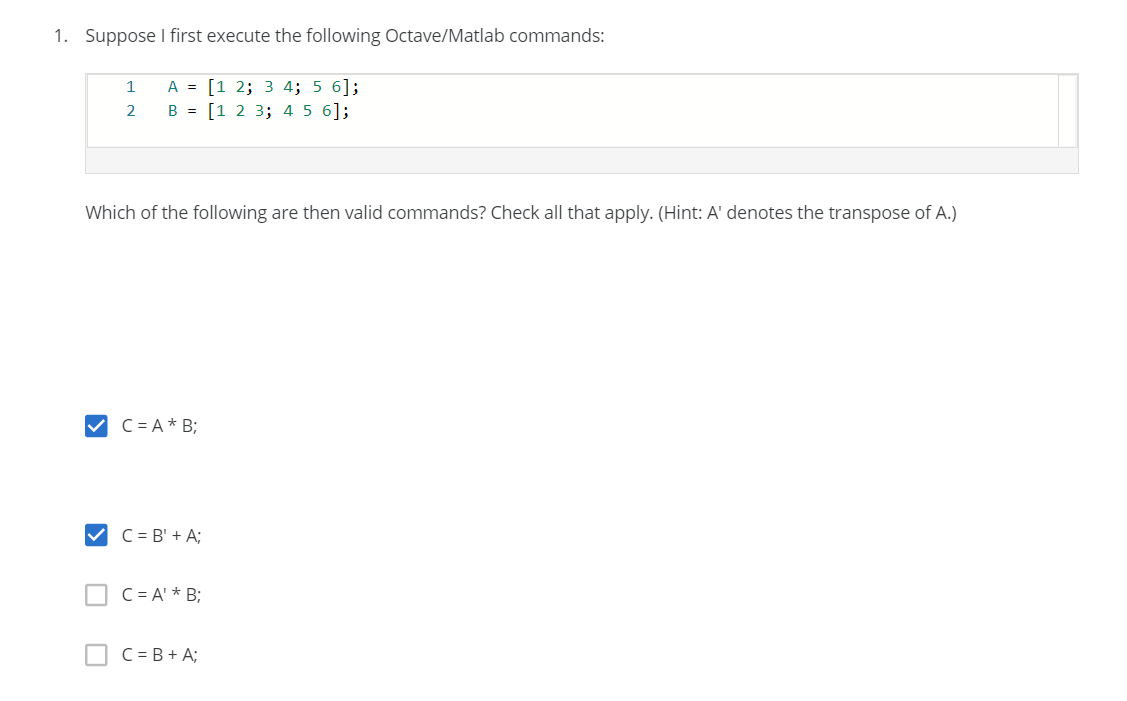

R2-1

解:

A矩阵是3 * 2,B矩阵为2 * 3。

A * B得到3 * 3矩阵,正确。

B’ + A,为3 * 2矩阵,正确。

A’与B不能相乘,错误。

A与B不能直接相加,错误。

R2-2

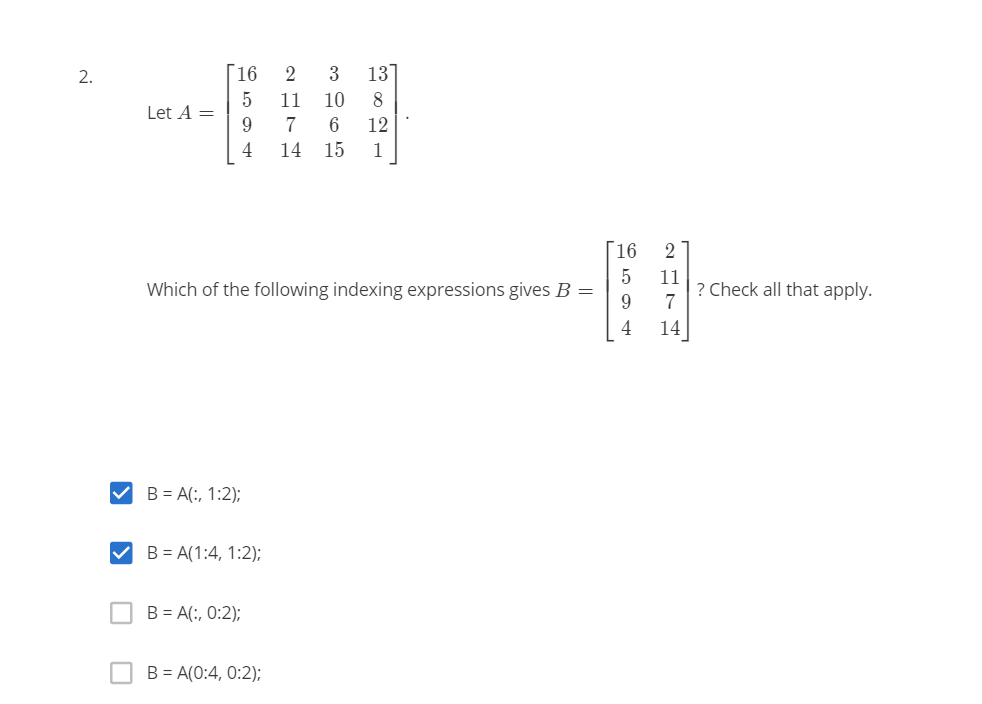

解:B是A的前两列,所以选择能取到前两列的选项。

R2-3

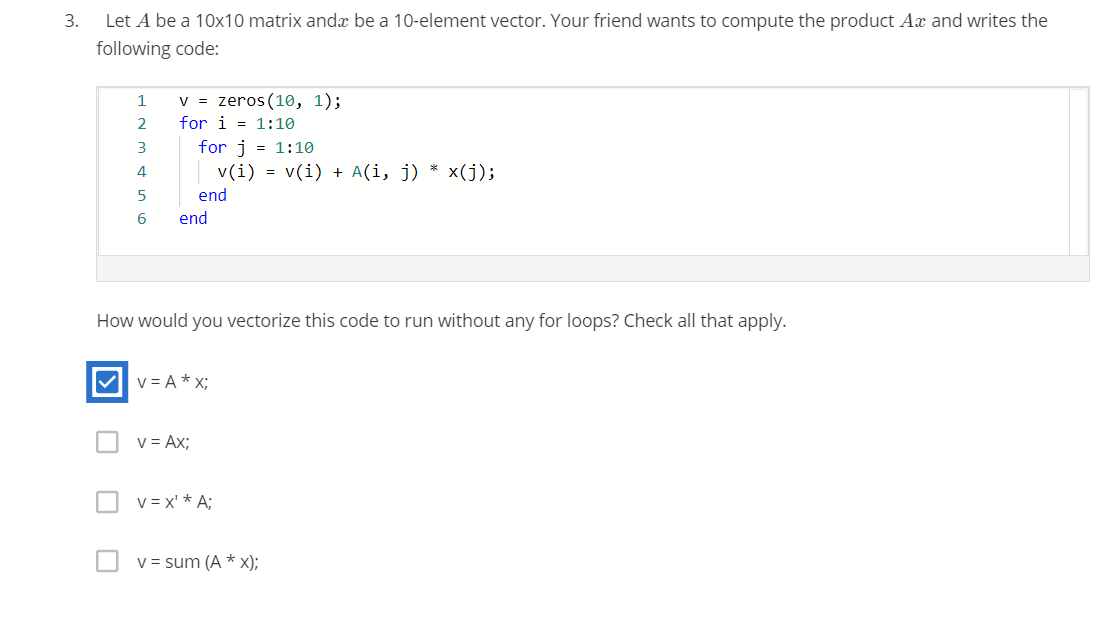

解:循环是用来得到每一维的结果,共10维。v是一个10 * 1的向量,v = A * x;

R2-4

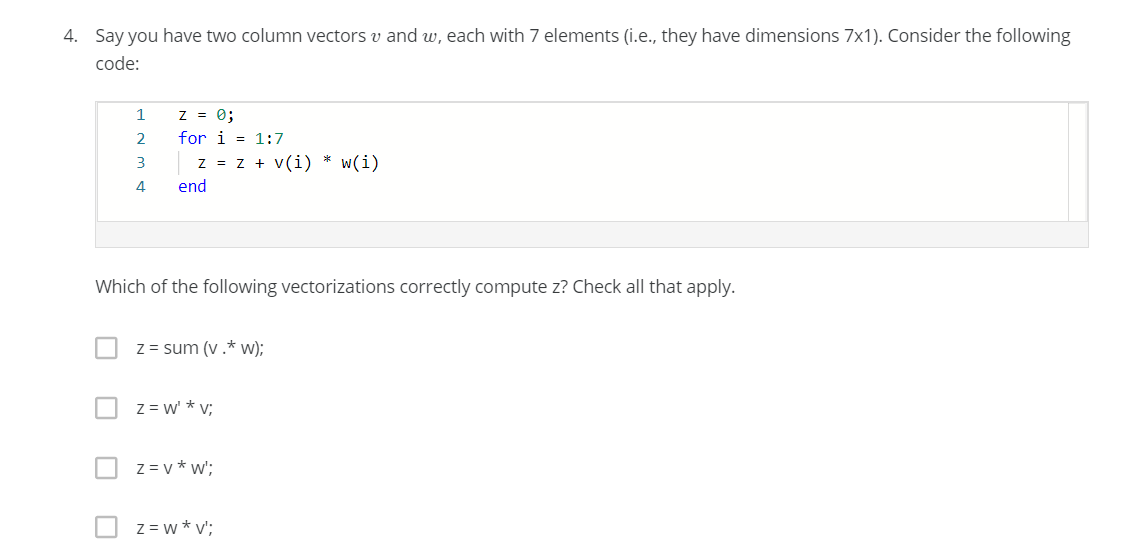

解:v向量是7 * 1 w向量是7 * 1, 上述代码的最终的结果是一个数值。

v .* w得到7*1的向量,再将所有值加到一起即可,正确。

w’ * v是也可以得到对应元素相乘加和,最后得到一个值,正确。

v * w’得到一个7 * 7的矩阵,不正确。

w * v’得到一个7 * 7的矩阵,不正确。

R2-5

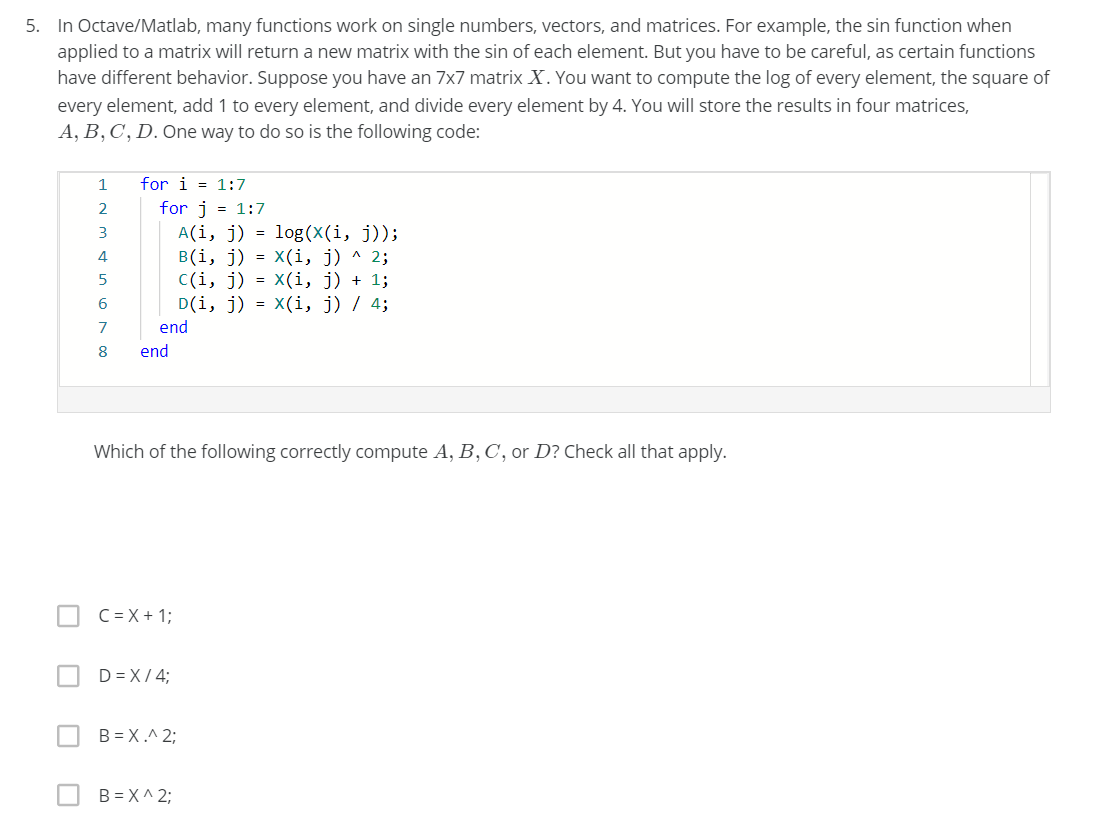

解:这里的每个操作都是针对单个元素的。

C = X + 1,正确。

D = X / 4,正确。

B = X .^ 2,正确。

不正确。